В этом блоге мы рассмотрим представленный ниже контент:

- Как настроить генерацию текста, загрузив модель с помощью «конвейерной» функции из преобразователей?

- Как использовать модель на основе трансформатора для генерации текста в PyTorch?

- Как использовать модель на основе трансформатора для генерации текста в TensorFlow?

Как настроить генерацию текста, загрузив модель с помощью «конвейерной» функции из преобразователей?

« трубопровод Функция используется для автоматической загрузки предварительно обученной модели ИИ в соответствии с требованиями пользователя. Чтобы использовать эту конкретную функцию, пользователям необходимо установить « трансформаторы » пакеты. Этот пакет предоставляет доступ к современным моделям на основе Transformer, которые могут выполнять анализ настроений, а также множество других функций. Обработка естественного языка (НЛП) задания.

Чтобы проверить практическую демонстрацию описанного выше сценария, перейдите к приведенным ниже шагам!

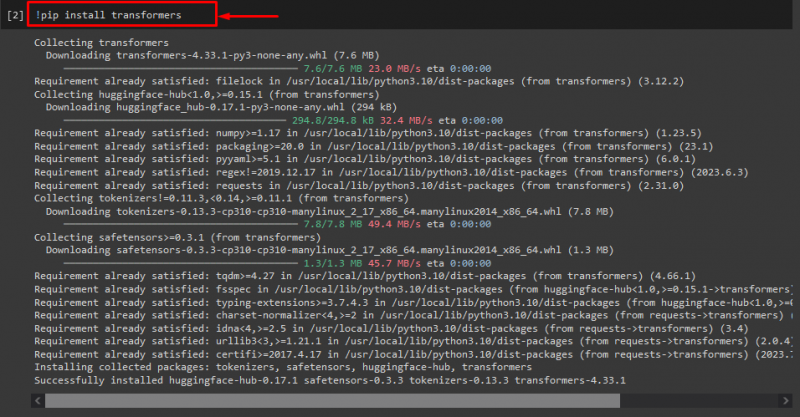

Шаг 1: Установите пакеты «трансформеры»

Первоначально выполните команду «! пип» команда для установки пакетов трансформера:

! установка трансформаторов

Как видите, указанный пакет успешно установлен:

Шаг 2. Импортируйте модель на основе трансформатора.

После этого импортируйте необходимую модель на основе трансформатора. Для этого сначала импортируйте файл « трубопровод ” функция из “ трансформаторы ». Затем используйте импортированную функцию и передайте « генерация текста ” в качестве аргумента вместе с требуемым названием модели “ gpt2 ». Затем передайте их в « генерировать ' переменная:

от трансформаторы Импортировать трубопровод

генерировать '=' трубопровод ( 'генерация текста' , модель '=' 'gpt2' )

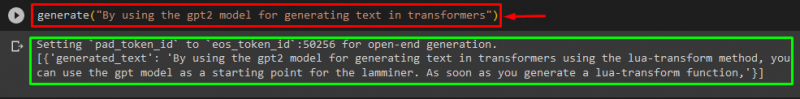

Шаг 3. Создайте персонализированный текст

Теперь передайте нужный текст в качестве аргумента функции « генерировать ». Как показано ниже:

генерировать ( «Используя модель gpt2 для генерации текста в трансформерах» )Согласно предоставленным результатам, загруженный предварительно обученный « gpt3 » модель успешно сгенерировала текст:

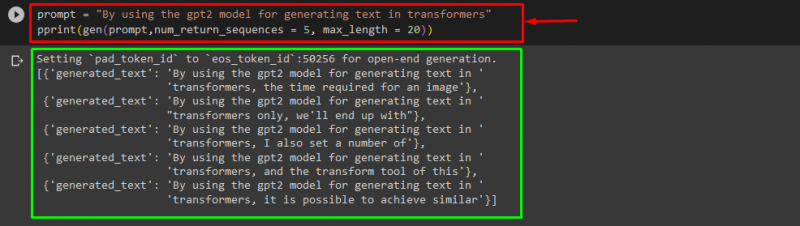

Вы также можете использовать другие аргументы, например:

быстрый '=' «Используя модель gpt2 для генерации текста в трансформерах»Распечатать ( ген ( быстрый , num_return_sequences '=' 5 , максимальная длина '=' двадцать ) )

Здесь:

- « быстрый используется в качестве аргумента, сохраняющего входные данные.

- « num_return_sequence Аргумент «используется для генерации количества последовательностей предоставленного текста.

- « максимальная длина Аргумент «используется для указания длины сгенерированного текста. В нашем случае оно ограничивается « 30 лексемы (слова или знаки препинания):

Примечание: Настраиваемый текст будет продолжением указанного приглашения, основанного на данных обучения модели.

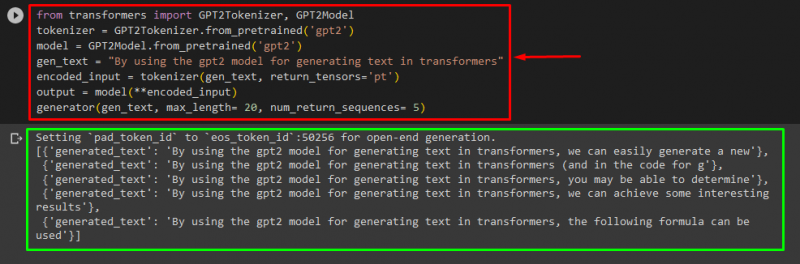

Как использовать модель на основе трансформатора для генерации текста в PyTorch?

Пользователи также могут настроить текст в « PyTorch ' какой ' Факел », основанная на машинном обучении. Он используется для различных приложений, таких как НЛП и компьютерное зрение. Чтобы использовать модель на основе преобразователя для настройки текста в PyTorch, сначала импортируйте файл « Токенизатор GPT2 ' и ' Модель GPT2 » функционирует из « трансформаторы »:

от трансформаторы Импортировать Токенизатор GPT2 , Модель GPT2Затем используйте « Токенизатор GPT2 токенизатор в соответствии с желаемой предварительно обученной моделью с именем « gpt2 »:

токенизатор '=' Токенизатор GPT2. from_pretrained ( 'gpt2' )После этого создадим экземпляры весов из предварительно обученной модели:

модель '=' Модель GPT2. from_pretrained ( 'gpt2' )Далее объявите « gen_text ” переменная, содержащая текст, который мы хотим настроить:

gen_text '=' «Используя модель gpt2 для генерации текста в трансформерах»Теперь передайте « gen_text ' и ' return_tensors = ‘pt’ » в качестве аргумента, который будет генерировать текст в PyTorch и сохранять сгенерированное значение в « закодированный_вход ' переменная:

закодированный_вход '=' токенизатор ( gen_text , return_tensors '=' 'пт' )Наконец, передайте « закодированный_вход ” переменная, которая содержит настроенный текст в “ модель » в качестве параметра и получить результирующий результат, используя « максимальная длина аргумент, для которого установлено значение « двадцать », что указывает на то, что сгенерированный текст будет ограничен предоставленными токенами, « num_return_sequences », который установлен на « 5 », который показывает, что сгенерированный текст будет основан на 5 последовательностях текста:

выход '=' модель ( **encoded_input )генератор ( gen_text , максимальная длина '=' двадцать , num_return_sequences '=' 5 )

Выход

Как использовать модель на основе трансформатора для генерации текста в TensorFlow?

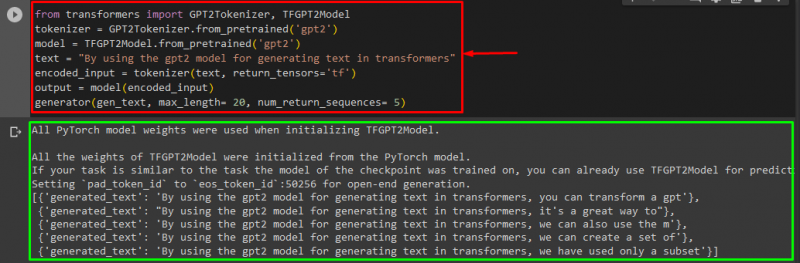

Для генерации текста в Трансформерах используется « Тензорфлоу Также используются платформы машинного обучения. Для этого сначала импортируйте необходимые функции, такие как « Токенизатор GPT2 ' и ' Модель TFGPT2 ' из ' трансформаторы ». Остальная часть кода такая же, как и выше, просто мы используем « Модель TFGPT2 ” вместо функции “ Модель GPT2 » функция. Следующим образом:

от трансформаторы Импортировать Токенизатор GPT2 , Модель TFGPT2токенизатор '=' Токенизатор GPT2. from_pretrained ( 'gpt2' )

модель '=' Модель TFGPT2. from_pretrained ( 'gpt2' )

текст '=' «Используя модель gpt2 для генерации текста в трансформерах»

закодированный_вход '=' токенизатор ( текст , return_tensors '=' 'тф' )

выход '=' модель ( закодированный_вход )

генератор ( gen_text , максимальная длина '=' двадцать , num_return_sequences '=' 5 )

Как видите, настроенный текст был успешно сгенерирован:

Вот и все! Мы подробно остановились на настройке генерации текста в Трансформерах.

Заключение

Чтобы настроить генерацию текста в Transformers, существуют разные способы, такие как загрузка модели с помощью функции конвейера или использование модели на основе преобразователя в « PyTorch ' и ' Тензорфлоу », которые основаны на платформах машинного обучения. В этом руководстве мы предоставили краткую информацию и практическую демонстрацию настройки генерации текста в Transformers.