LangChain — это платформа, содержащая множество зависимостей и библиотек, которые можно использовать для создания больших языковых моделей. Эти модели можно использовать для взаимодействия с людьми, но сначала модель должна научиться получать/понимать подсказку/вопрос, задаваемый человеком. Для этого модель необходимо обучить на шаблонах подсказок, а затем пользователь задает вопрос в рамках данного шаблона.

В этом руководстве будет показан процесс создания шаблонов подсказок в LangChain.

Как создать шаблоны подсказок в LangChain?

Чтобы создать шаблоны подсказок в LangChain, просто следуйте следующему руководству, состоящему из нескольких шагов:

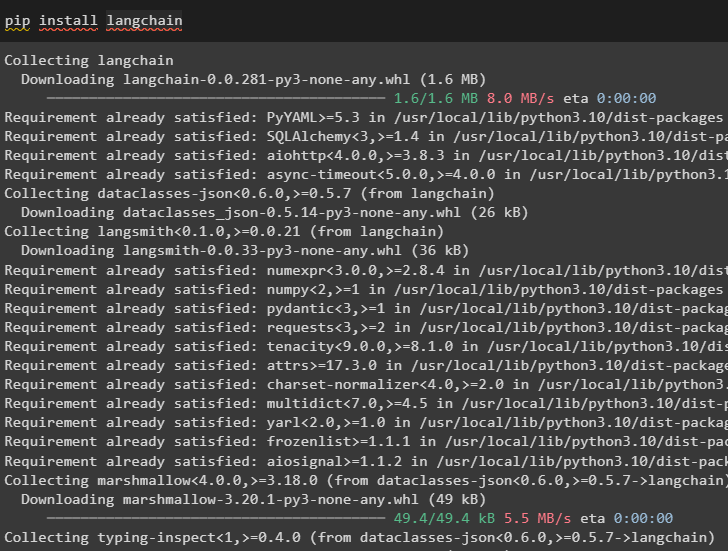

Шаг 1. Установите модули и среду настройки.

Запустите процесс создания шаблонов подсказок в LangChain, установив инфраструктуру LangChain:

pip установить langchain

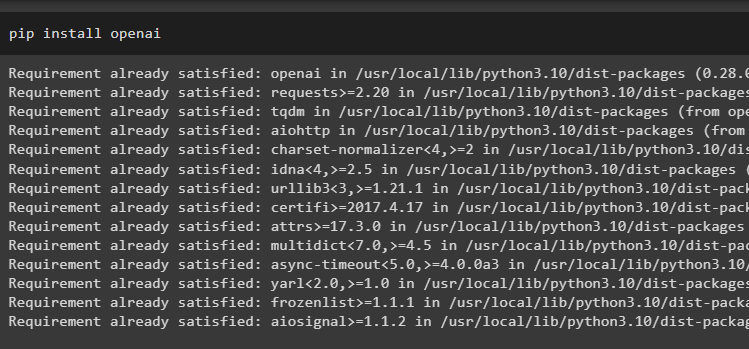

Теперь установите модули OpenAI для доступа к его библиотекам и настройте среду с их использованием:

pip установить openai

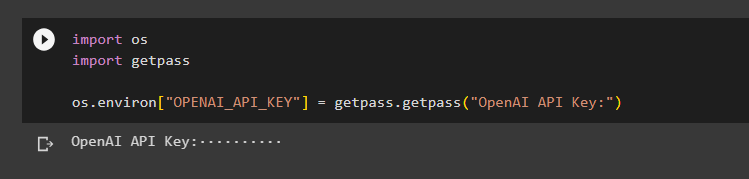

Настройте среда OpenAI использование библиотеки os для доступа к операционной системе и предоставления ключа API OpenAI:

импортируйте насимпортировать getpass

os.environ['OPENAI_API_KEY'] = getpass.getpass('Ключ API OpenAI:')

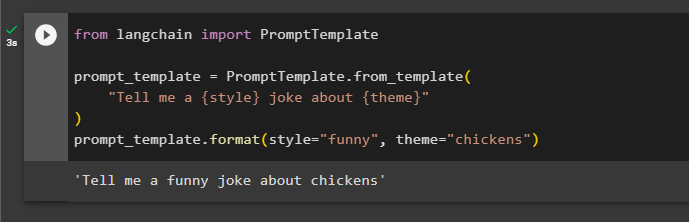

Шаг 2. Использование шаблона приглашения

После установки LangChain просто импортируйте библиотеку PromptTemplate и создайте шаблон для запроса о шутке с некоторыми дополнительными аспектами в виде переменных, таких как прилагательное, содержание и т. д.:

из импорта langchain PromptTemplatePrompt_template = PromptTemplate.from_template(

«Расскажи мне шутку в стиле {style} на {theme}»

)

Prompt_template.format(style='смешно', theme='куры')

Подсказка была установлена и передана модели со значениями переменной, вставленной в команду:

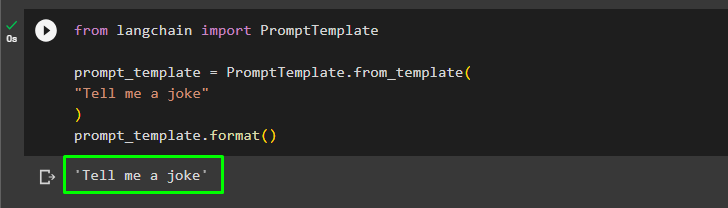

Пользователь может настроить шаблон приглашения с помощью простого запроса с просьбой пошутить:

из импорта langchain PromptTemplatePrompt_template = PromptTemplate.from_template(

'Расскажи мне шутку'

)

Prompt_template.format()

Вышеупомянутый метод предназначен для одного запроса и ответа, но иногда пользователь хочет взаимодействовать с моделью в форме чата, и в следующем разделе объясняется его формат.

Шаг 3. Использование шаблона подсказки чата

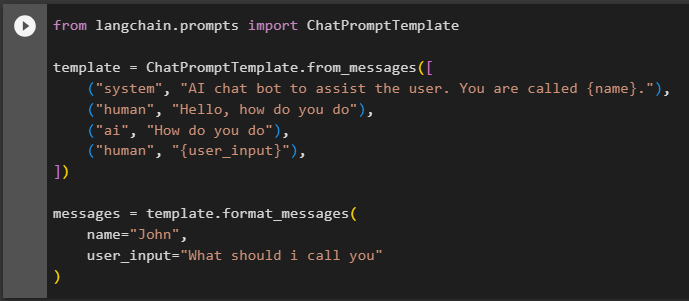

В этом разделе объясняется шаблон модели чата, основанный на шаблоне разговора, например, когда два человека взаимодействуют друг с другом:

из langchain.prompts импорт ChatPromptTemplateшаблон = ChatPromptTemplate.from_messages([

(«система», «Чат-бот с искусственным интеллектом для помощи пользователю. Вас зовут {имя}.»),

(«человек», «Привет, как дела»),

(«ай», «Как дела»),

('человек', '{user_input}'),

])

сообщения = template.format_messages(

,

user_input='Как мне вас называть'

)

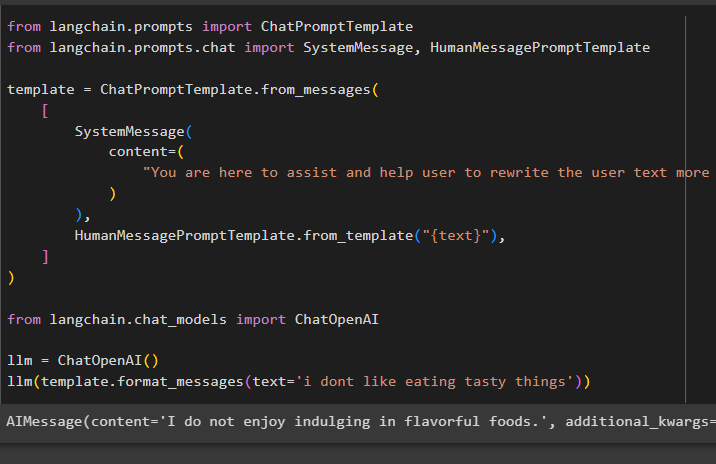

После настройки структуры шаблона просто напишите несколько строк в тексте, чтобы сообщить модели, что от нее ожидается, и используйте функцию llm() для получения подсказки:

из langchain.prompts импорт ChatPromptTemplateиз langchain.prompts.chat импортировать SystemMessage, HumanMessagePromptTemplate

шаблон = ChatPromptTemplate.from_messages(

[

СистемноеСообщение(

содержание=(

«Вы здесь, чтобы помочь пользователю более эффективно переписать пользовательский текст»

)

),

HumanMessagePromptTemplate.from_template('{text}'),

]

)

из langchain.chat_models импортировать ChatOpenAI

llm = ЧатOpenAI()

llm(template.format_messages(text='я не люблю есть вкусное'))

Метод SystemMessage() содержит содержимое ответа на запрос, используемый в LLM:

Это все, что касается создания шаблонов подсказок в LangChain.

Заключение

Чтобы создать шаблон приглашения в LangChain, просто установите модули LangChain и OpenAI, чтобы настроить среду с использованием ключа API OpenAI. После этого создайте шаблон подсказки для одной подсказки, например, для шутки или одного вопроса о чем-либо. Другой метод — настройка шаблона модели чата, основанной на процессе взаимодействия двух разных людей. В этом посте проиллюстрирован процесс создания шаблона приглашения в LangChain.