Это руководство проиллюстрирует процесс запуска LLMChains в LangChain.

Как запустить LLMChains в LangChain?

LangChain предоставляет функции или зависимости для создания LLMChains с использованием LLM/чат-ботов и шаблонов подсказок. Чтобы изучить процесс создания и запуска LLMChains в LangChain, просто следуйте следующему пошаговому руководству:

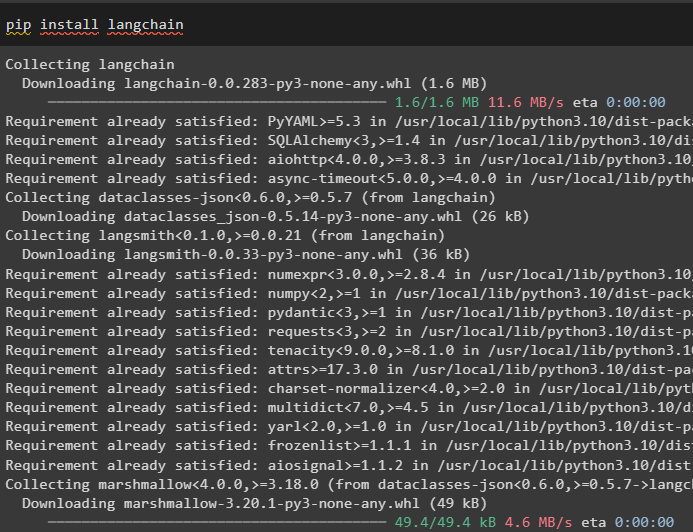

Шаг 1. Установите пакеты

Сначала начните процесс с установки модуля LangChain, чтобы получить его зависимости для сборки и запуска LLMChains:

pip установить langchain

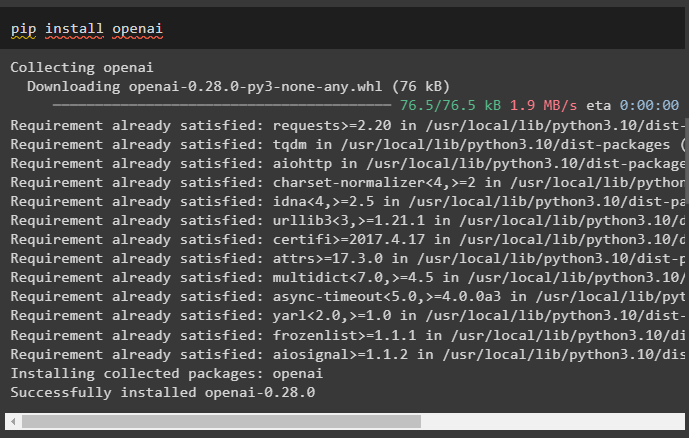

Установите платформу OpenAI с помощью команды pip, чтобы библиотеки могли использовать функцию OpenAI() для создания LLM:

pip установить openai

После установки модулей просто настроить среду переменные с использованием API-ключа от учетной записи OpenAI:

Импортировать ты

Импортировать получить пропуск

ты . примерно [ 'ОПЕНАЙ_API_KEY' ] '=' получить пропуск . получить пропуск ( «Ключ API OpenAI:» )

Шаг 2. Импортируйте библиотеки

После завершения установки и установки всех необходимых пакетов импортируйте необходимые библиотеки для создания шаблона приглашения. После этого просто создайте LLM, используя метод OpenAI(), и настройте LLMChain, используя LLM и шаблон приглашения:

от Лангчейн Импортировать Шаблон приглашенияот Лангчейн Импортировать ОпенАИ

от Лангчейн Импортировать ЛМЧейн

подсказка_шаблон '=' 'дайте мне хорошее название для компании, производящей {продукт}?'

лм '=' ОпенАИ ( температура '=' 0 )

llm_chain '=' ЛМЧейн (

лм '=' лм ,

быстрый '=' Шаблон запроса. from_template ( подсказка_шаблон )

)

llm_chain ( «яркая одежда» )

Шаг 3: Запуск цепей

Получите входной список, содержащий различные продукты, производимые предприятием, и запустите цепочку, чтобы отобразить список на экране:

входной_список '=' [{ 'продукт' : 'носки' } ,

{ 'продукт' : 'компьютер' } ,

{ 'продукт' : 'обувь' }

]

llm_chain. применять ( входной_список )

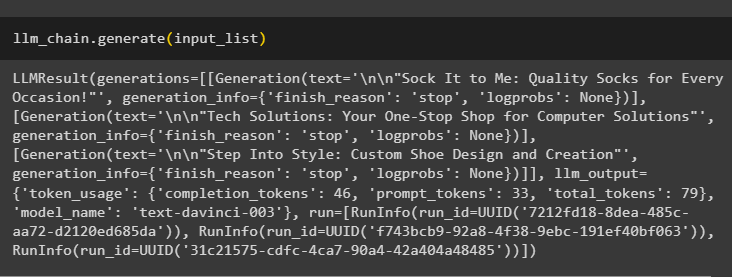

Запустите методgenerate(), используя входной_список с LLMChains, чтобы получить выходные данные, связанные с диалогом, сгенерированным моделью:

llm_chain. генерировать ( входной_список )

Шаг 4: Использование одного входа

Добавьте еще один продукт для запуска LLMChains, используя только один вход, а затем спрогнозируйте, что LLMChain сгенерирует выходные данные:

llm_chain. предсказывать ( продукт '=' «разноцветные носки» )Шаг 5: Использование нескольких входов

Теперь создайте шаблон для использования нескольких входов для предоставления команды модели перед запуском цепочки:

шаблон '=' '''Расскажи мне шутку о {прилагательном} на тему {subject}.'''быстрый '=' Шаблон приглашения ( шаблон '=' шаблон , входные_переменные '=' [ 'прилагательное' , 'предмет' ] )

llm_chain '=' ЛМЧейн ( быстрый '=' быстрый , лм '=' ОпенАИ ( температура '=' 0 ) )

llm_chain. предсказывать ( прилагательное '=' 'грустный' , предмет '=' 'утки' )

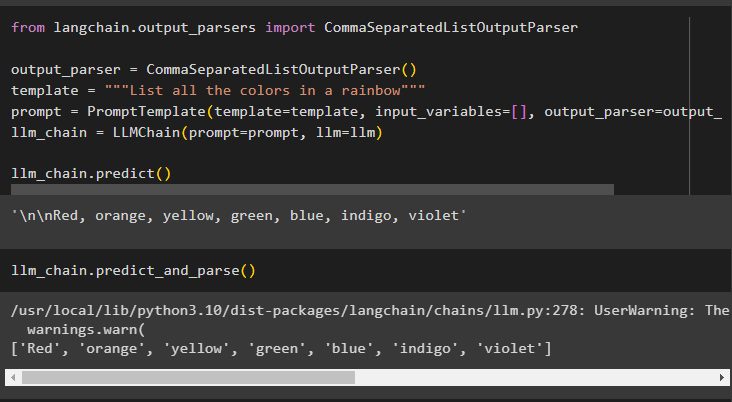

Шаг 6: Использование анализатора вывода

На этом шаге используется метод синтаксического анализатора вывода для запуска LLMChain и получения вывода на основе приглашения:

от лангчейн. выходные_парсеры Импортировать CommaSeparatedListOutputParserвыходной_парсер '=' CommaSeparatedListOutputParser ( )

шаблон '=' '''Перечислите все цвета радуги'''

быстрый '=' Шаблон приглашения ( шаблон '=' шаблон , входные_переменные '=' [ ] , выходной_парсер '=' выходной_парсер )

llm_chain '=' ЛМЧейн ( быстрый '=' быстрый , лм '=' лм )

llm_chain. предсказывать ( )

Использование метода parse() для получения выходных данных создаст список всех цветов радуги, разделенных запятыми:

llm_chain. предсказать_and_parse ( )

Шаг 7: Инициализация из строк

На этом шаге объясняется процесс использования строки в качестве приглашения для запуска LLMChain с использованием модели и шаблона LLM:

шаблон '=' '''Расскажи мне шутку о {прилагательном} на тему {subject}'''llm_chain '=' LLMChain. from_string ( лм '=' лм , шаблон '=' шаблон )

Укажите значения переменных в строковой подсказке, чтобы получить выходные данные модели, запустив LLMChain:

llm_chain. предсказывать ( прилагательное '=' 'грустный' , предмет '=' 'утки' )Это все, что касается запуска LLMChains с использованием инфраструктуры LangChain.

Заключение

Чтобы создать и запустить LLMChains в LangChain, установите необходимые компоненты, такие как пакеты, и настройте среду, используя ключ API OpenAI. После этого импортируйте необходимые библиотеки для настройки шаблона приглашения и модели для запуска LLMChain с использованием зависимостей LangChain. Пользователь может использовать анализаторы вывода и строковые команды для запуска LLMChains, как показано в руководстве. В этом руководстве подробно описан полный процесс запуска LLMChains в LangChain.